OpenAI ha lanciato un nuovo modello di intelligenza artificiale generativa chiamato GPT-4o, dove la “o” sta per “omni”. Questo modello è in grado di gestire testo, voce e video, e rappresenta un passo avanti per l’azienda nel mantenere la leadership nel settore delle tecnologie emergenti. Nelle prossime settimane sarà implementato “iterativamente” nei prodotti destinati agli sviluppatori e ai consumatori. Nel corso dell’evento c’è anche stato modo di annunciare il lancio di un’applicazione desktop di ChatGPT (con tanto di conferma dell’integrazione della funzione Voice). Quest’ultima verrà inizialmente resa disponibile su macOS per gli utenti ChatGPT Plus, ma è previsto un lancio più esteso in futuro. Inoltre, una versione per Windows arriverà più avanti nel corso del 2024. Qui trovate la cronaca dell’evento di Alessandro Longo

Le prestazioni e i numeri È in grado di rispondere agli input audio in appena 232 millisecondi, con una media di 320 millisecondi, un tempo simile a quello di risposta umana (si apre in una nuova finestra) in una conversazione.

Rispetto al modello precedente, 4.0 Turbo, è due volte più veloce, costa la metà a OpenAI grazie alle efficienze raggiunte (e questo permetterà di abbattere prezzi ed estendere alcune funzioni a utenti gratuiti) e ha limiti di frequenza cinque volte più alti (parametro che indica la frequenza con cui gli utenti possono fare richieste al modello, per esempio, per generare testo, analizzare dati o interagire in altre modalità). Il nuovo modello ha anche migliorato la qualità e la velocità di ChatGpt per 50 lingue diverse e sarà disponibile anche tramite l’API di OpenAI, in modo che gli sviluppatori possano iniziare a costruire applicazioni utilizzando il nuovo modello oggi

Cosa sa fare di diverso? Colpisce la capacità di interloquire con le persone assumendo tratti umani. Ci basiamo sulla demo che potete vedere sopra. Quindi andrà provato. Ecco alcuni comportamenti che ci hanno colpito.

Il chatbot capisce le emozioni. Nella demo l’utente era troppo emozionato (respirava velocemente) e lo ha aiutato a calmarsi, con qualche consiglio, offerto con una voce calda e persuasiva, a mo’ di coach. Mark Chen, ricercatore di OpenAI, ha detto che il modello è in grado di “percepire le vostre emozioni”. Il team gli ha anche chiesto di analizzare l’espressione facciale di un utente e di commentare le emozioni che la persona potrebbe provare. Ha capito che stava sorridendo e ne ha dedotto che era felice in quel momento.

Cambia tono della voce. Il chatbot è in grado di cambiare registro e tono a seconda di quello che desideriamo.

Coding e matematica. Sappiamo che le scienze dure sono quelle più difficili da imparareNella demo ha risolto equazioni matematiche, con una guida vocale passo passo utile agli studenti, per scrivere codice

Quando arriverà? La notizia è che sarà disponibile per gli utenti gratuiti di ChatGPT, GPT-4o verrà prima distribuito agli abbonati a pagamento: Gli utenti Plus avranno un limite di messaggi fino a 5 volte superiore a quello degli utenti free, mentre gli utenti Team ed Enterprise avranno limiti ancora più elevati”.

Nell’API, GPT-4o sarà disponibile a un prezzo dimezzato e a una velocità doppia rispetto a GPT-4 Turbo, oltre a limiti di velocità aumentati di 5 volte – la quantità di chiamate che gli sviluppatori di terze parti possono effettuare in un dato momento – secondo i post del cofondatore e CEO di OpenAI Sam Altman su X durante l’evento.

Per approfondire.

Cosa è Microsoft Places? Ecco come funziona la nuova applicazione per la gestione dei luoghi

Come si installa e come funziona Phi-3 di Microsoft #DatavizAndTools

Come funzionano le nuove estensioni di Gemini?

Gpt-4, Gemini e Gemini 1.5 Pro. Scopri le differenze

Cerchia e cerca e altre novità Ai di Google sui telefonini Android

Come funziona Sima la nuova Ai di Google che completa i videogiochi al posto vostro

Come funziona e a cosa serve Ecco lo European Statistical Monitor?

Claude 3 di Anthropic è più potente di ChatGPt? Ecco quello che c’è da sapere.

Nasce Genie, il modello di Ai per creare videogiochi da una singola immagine

Ecco cosa promette il generatore di immagini Stable Diffusion 3

Gemma 2B e Gemma 7B. Ecco cosa si può fare con i modelli open source di Gemini

Da Adobe domande e riassunti con l’Ai gen su documenti Pdf

Nasce Sora il modello text-to-video di OpenAi. Ecco come funziona

Come funziona Lumiere l’Ai di Google che genera video dal testo #DatavizAndTools

Microsoft Copilot ora è su tutti gli smartphone. #DatavizAndTools

Come funzionano Nightshade e Glaze? #DatavizAndTools

Fotoritocco, come funzionano Abobe Photoshop Elements e Premiere? #DatavizAndTools

Ecco come funziona Q il nuovo chatbot di AWS? #DatavizAndTools

Ecco come funziona Microsoft 365 Copilot, l’AI generativa entra nelle app di Office

Ecco come funziona GraphCast il nuovo modello per le previsioni meteorologiche globali di DeepMind

Cosa è e come funziona Code Interpreter per Gpt-4?

Come riconoscere immagini e testi generati dall’AI?

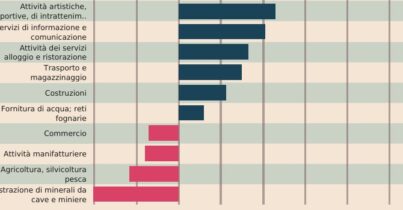

La matematica della ricchezza, la disuguaglianza inevitabile e l’econofisica

Wikipedia, l’intelligenza collettiva e gli affari #datavizandtool

Come si costruisce una mappa di Milano con ChatGpt? #datavizandtools

Come funziona MusicGen, il ChatGpt della musica di Meta #DatavizandTools

Bing, come funziona il copilota di Microsoft per il web? #DatavizAndTools

Le ultime novità “audio” dell’Ai generativa #DatavizAndTools

Gpt-4 vs Bard, cinque domande: chi risponde meglio? #howmeasuring

A proposito di mappe, cosa è Overture Maps Foundation? #DatavizAndTools

Ecco le nuove funzionalità di intelligenza artificiale generativa di Photoshop