Meta Llama 3 è il nuovo modello di linguaggio di grandi dimensioni (LLM) presentato giovedì scorso dalla società guidata da Mark Zuckerberg. Completamente open source, è stato addestrato su due cluster con oltre 24.000 GPU NVIDIA. “I modelli testuali che rilasciamo oggi sono i primi della collezione di modelli Llama 3. Il nostro obiettivo nel prossimo futuro è rendere Llama 3 multilingue e multimodale, avere una finestra di contesto più lunga e continuare a migliorare le prestazioni complessive delle funzionalità LLM fondamentali come il ragionamento e la codifica”.

Il nuovo modello è presentato in due versioni: quello chiamato 8B e il 70B. Non sono sigle casuali: significa che i modelli sono addestrati rispettivamente su 8 e 70 miliardi di parametri, cioè le unità fondamentali di conoscenza che le IA usano per comprendere e interpretare il mondo. Inutile dirlo: più sono, migliore sarà l’algoritmo. E per non farsi mancare nulla, in un futuro non troppo lontano dovrebbe arrivare il modello alimentato con 400 miliardi di parametri.

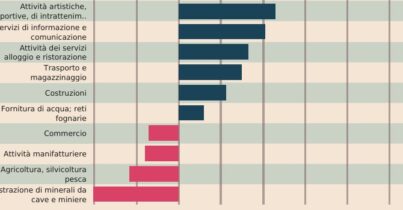

Qui sotto trovate come si sono comportati in base al alcuni indici rispetto ad altri modelli Open Source

Qualche giorno prima, anzi una settimana prima a Las Vegas Google ha presentato Viene presentato come il primo modello più grande di Google e completamente multimodale cioè permette di gestire in input testo, immagini e, per la prima volta, i video.

La “finestra di contesto” di un modello di intelligenza artificiale è costituita da token, che sono gli elementi costitutivi utilizzati per l’elaborazione delle informazioni. I token possono essere intere parti o sottosezioni di parole, immagini, video, audio o codice. Quanto più grande è la finestra di contesto di un modello, tanto più informazioni può accogliere ed elaborare in un dato prompt, rendendo il suo output più coerente, pertinente e utile.

Con Gemini 1.5 Pro si ha la possibilità di gestire fino a un milione di token, che si traduce nella possibilità di lavorare con testi di oltre 700.000 parole, 11 ore di audio e 1 ora di video. Va ricordato che, al momento, ChatGPT versione web arriva a 8.000 , Gemini 1.0 Pro a 32.000, GPT-4 Turbo a 128.000 e Claude 2 a 200.000. Qui in un post di Info Data nella sezione Dataviz trovate i benchmark e altre informazioni.

Proviamo a unire i punti. Siete su Ascanio e questa è le 20esima lezione di Ai gen.

Cosa è Ascanio? E’ un format video di Info Data dove si discute a ruota libera di giornalismo, attualità e dati rigorosamente senza una scaletta. Buona visione.

Per approfondire.

Gemma, Sora e le altre (Ai). Lezione 18 di Ai gen #Ascanio

Gpt4 vs Gemini Advanced. Ecco la nostra prova #Ascanio

Gemini, il nuovo modello multimodale di Google e l’Ai Act. Lezioni di Ai Gen 13 #Ascanio

Python, coding e Gpt-4. Come si programma con l’Ai generativa? #Ascanio

Il blocco di ChatGpt, la privacy e il Bing Image Creator. Lezione 2

A lezione con Gpt-4. Il futuro dell’informazione. Lezione 1

Marketing, newsletter e social con Gpt-4. Lezione 06/23

Bard, l’ai responsabile e la privacy. Lezione 07/23

Fogli di calcolo, grafici e analisi dei dati con Advanced Data Analysis. Lezione 08/23

Hollywood, gli attori, i cloni e le voci clonate. Lezione 09/23

Le illusioni ottiche dell’intelligenza artificiale, Llava e le foto fake. Lezione 10

Gpt-4 e Bard non sono più quelli di una volta Lezione 11 di Ai Gen

Gpts, operazione Altman e Copilot Copyright Commitment. Lezione di Ai Gen 12

Video, animazioni e deep fake in tempo reale. Lezione di Gen Ai 14/24

Galaxy AI, Gemini Nano e l’intelligenza on-device. Lezione 15 #Ascanio

Chatbot pigri, il Gpt Store e Lumiere il nuovo modello generativo di Google. Lezione 16 #Ascanio