Chi legge abitualmente le principali riviste scientifiche o segue profili che si occupano di questo tema non può non aver notato che nell’ultimo anno il numero di articoli dedicati a come l’IA sta impattando sulla modalità attraverso la quale la ricerca pubblica i propri risultati è cresciuto in maniera evidente.

La peer review è il collo di bottiglia della ricerca scientifica. Un ciclo di revisione può durare anche sei mesi, un tempo incompatibile con le esigenze economico-finanziarie delle aziende, che hanno bisogno di lanciare il proprio prodotto. Non a caso la maggior parte degli annunci dei big tech che riguardano ambiti propriamente di ricerca scientifica – come la medicina – rimanda ad ArXiv, una piattaforma dove si possono pubblicare i propri lavori in pre-print, ossia che magari sono anche stati inviati a una rivista scientifica, ma che ancora non hanno superato una revisione fra pari.

La vera posta in gioco è il tempo

È da qui che nasce Agentic Reviewer, il nuovo strumento rilasciato da Andrew Ng insieme a Yixing Jiang, un dottorando in Machine Learning all’Università di Stanford per fornire feedback su articoli scientifici in pochi minuti. Il sistema non si pone dunque come un sostituto dei revisori umani (dicono), né come un giudice automatico delle submission, ma come un acceleratore di feedback. Invece di aspettare sei mesi per scoprire che mancano baseline importanti o che una sezione è poco chiara, un ricercatore può saperlo subito, correggere, rifare un esperimento, riscrivere.

Questo cambia il modo di lavorare. Avvicina la ricerca a cicli brevi e iterativi, simili a quelli dell’ingegneria. Riduce la sensazione di essere bloccati in un limbo temporale fatto di attese e silenzi.

Chi è Andrew Ng

Oltre a lavorare come professore a Contratto presso il Dipartimento di Informatica della Stanford University, Andrew Ng è il fondatore di DeepLearning.AI, Presidente Esecutivo di LandingAI, General Partner di AI Fund, e Presidente e Co-Fondatore di Coursera.

1. Come lavora Agentic Reviewer

Agentic Reviewer non è un semplice chatbot che commenta un PDF. Il primo passaggio consiste nel trasformare l’articolo in un formato leggibile e stabile per una macchina. I PDF, infatti, sono notoriamente difficili da interpretare per i modelli linguistici: formule spezzate, tabelle illeggibili, sezioni che spariscono.

Per questo il sistema converte il documento in Markdown, un formato testuale strutturato. Solo dopo verifica che si tratti effettivamente di un articolo scientifico. Se non lo è, il processo si ferma. Sembra un dettaglio tecnico, ma è uno dei punti in cui molti sistemi simili falliscono.

È un dettaglio tecnico che conta: molti tentativi di revisione automatica falliscono perché il modello “legge” male il paper—equazioni corrotte, tabelle illeggibili, sezioni perse. La normalizzazione in Markdown riduce drasticamente questi errori.

A questo punto, un agente verifica che il documento sia effettivamente un articolo scientifico. Se non lo è, il processo si interrompe. Niente token sprecati per rivedere slide o documenti inconsistenti.

2. Grounding nella letteratura recente

È qui che l’Agentic Reviewer si differenzia davvero. Invece di affidarsi alla memoria implicita del modello, il sistema cerca attivamente lavori correlati su arXiv.

Lo fa generando più query, a diversi livelli di specificità: benchmark vicini, lavori che affrontano lo stesso problema, articoli metodologicamente affini.

Le ricerche passano attraverso l’API di Tavily, che recupera metadati da arXiv (titoli, abstract, autori). Da lì, un agente valuta la rilevanza e seleziona i contributi più pertinenti. Quando un’AI come l’Agentic Reviewer ha bisogno di vedere cosa è già stato pubblicato online — per esempio altri paper simili su arXiv — non può fare affidamento soltanto sulle informazioni che ha “dentro” il suo modello (che sono statiche e si fermano a un certo periodo di addestramento). Ha bisogno di cercare sul web in tempo reale e riportare risultati accurati. L’API di Tavily permette proprio questo: di inviare una domanda (una query) ottenendo risultati rilevanti, filtrati e già pronti per essere usati da un modello AI.

3. Le domande giuste

Infine, l’agente combina il contenuto del paper con i riassunti della letteratura e produce una revisione seguendo un template coerente. Si chiede per esempio:

Le affermazioni sono supportate dai risultati?

Mancano baseline rilevanti o aggiornate?

La novità è solida rispetto ai lavori adiacenti?

Ci sono passaggi tecnicamente poco chiari?

In altre parole, il tipo di commenti che gli autori sperano di ricevere, ma che spesso arrivano in forma ellittica o tardiva.

Uno score “oggettivo”

Invece di limitarsi a dire “le review dell’AI sembrano buone”, il team ha deciso di misurare in modo numerico quanto il sistema si comporti come un revisore reale. Per farlo ha usato dati veri, non simulati.

ICLR (International Conference on Learning Representations) rende pubbliche molte delle sue review. Per l’edizione 2025, esistono quindi valutazioni scritte e punteggi assegnati da revisori umani reali su centinaia di articoli.

Il team ha preso queste review pubbliche e le ha usate per addestrare la parte del sistema che assegna i punteggi (la “componente di scoring”).

Il risultato è stato notevole: la correlazione tra revisori umani si attesta intorno a 0,41, mentre la correlazione tra il punteggio dell’AI e quello umano arriva a 0,42.

In pratica, il sistema raggiunge un livello di accordo paragonabile a quello tra revisori in carne e ossa. Non perfezione, ma realismo: la peer review umana, dopotutto, è tutt’altro che uniforme.

Questi sistemi fanno bene alla ricerca o ai ricercatori?

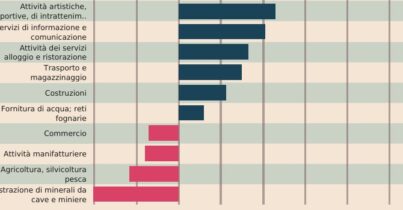

C’è poi un altro aspetto tangente a questo tema, che vale la pena citare. Gli strumenti di intelligenza artificiale aumentano la produttività dei singoli scienziati, ma potrebbero limitare la ricerca nel suo complesso. Negli stessi giorni un’analisi di centinaia di migliaia di articoli scientifici pubblicata su Nature ha evidenziato un paradosso: gli scienziati che utilizzano strumenti di IA producono sì più ricerche, ma su un insieme di argomenti più ristretto. Quindi più boost individuale ma meno interazione. Chi utilizza strumenti di IA ottiene vantaggi tangibili: pubblica tre volte più articoli, riceve quasi cinque volte più citazioni e raggiunge ruoli di leadership più rapidamente rispetto ai colleghi senza IA. Al tempo stesso gli articoli AI-driven ricevono il 22% in meno di interazioni con altri studi rispetto a quelli tradizionali e che gran parte delle citazioni si concentra su un numero molto ristretto di “paper superstar”.

Per approfondire

OpenAI lancia Prism: il vibe coding applicato alla scienza

Contro il “dottor ChatGpt” serve più cultura scientifica e statistica

L’intelligenza artificiale può aiutare la ricerca scientifica? Forse anche troppo