Sono state pubblicate delle foto generate con il modello di Ai Gemini di Google con nazisti di colore o vikinghi che sembrano pellerossa. L’operazione (il prompt) non è stato artistico. Nel senso che l’autore ha chiesto immagini di nazisti e il generatore di immagini ha reagito nel modo più politicamente corretto e inclusivo possibile mettendo orientali e afroamericani con la divisa delle SS. Qualcuno ha alzato la mano e ha protestato chiedendo un po’ di contesto storico e Google ha bloccato temporaneamente il suo nuovo modello di intelligenza artificiale che produce immagini di persone. Qui sotto il tweet che è curioso nel contento.

We’re aware that Gemini is offering inaccuracies in some historical image generation depictions. Here’s our statement. pic.twitter.com/RfYXSgRyfz

— Google Communications (@Google_Comms) February 21, 2024

Siamo consapevoli del fatto che Gemini presenta inesattezze in alcune rappresentazioni storiche della generazione di immagini. Ecco la nostra dichiarazione.

Come ha poi specificato Jack Krawczyk, direttore senior del team Gemini di Google, al Guardian “Nell’ambito dei nostri principi AI https://t.co/BK786xbkey , progettiamo le nostre capacità di generazione di immagini per riflettere la nostra base di utenti globale”.

Cosa vuole dire? Che i chatbot leggono non hanno prospettiva storica ma leggono le immagini statistiche di chi naviga su internet, nel modo – aggiungiamo noi – più inclusivo possibile. Gesù può essere di biondo e con gli occhi azzurri anche se è nato in Medio Oriente (come peraltro era ritratto dagli artisti nel medioevo). Così come i Samurai possono avere la pelle bianca.

C’è chi si è scandalizzato, ha chiamato sul banco degli imputati la cancel culture e l’ideologia Woke imputando a quelli del politicamente corrette l’intento di appiattire tutto (anche la Storia) per rendere tutto aperto e inclusivo.

Come se il tentativo di raddrizzare i pregiudizi di genere dei chatbot portasse inevitabilmente a una riscrittura della storia.

Il problema però non è la tecnologia ma siamo noi e quello che chiediamo a questi strumenti.

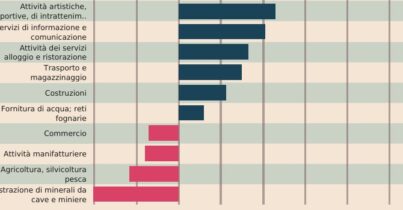

Fin dalla comparsa dei chatbot e dei generatori di immagini ci si è accordi che questi sistemi erano vittime degli stereotipi. Qui sotto alcuni esempi, ma ce ne sarebbero molti altri. Se chiedete a Stable Diffusion di disegnarvi un povero sceglierà una persona di colore. Così come un terrorista viene identificato con un arabo.

Quello che è bene ricordare è che i chatbot sono razzisti e sessisti perché la loro base sono spesso i dati presi dal web. E i dati del web raccontano in modo quantitativamente corretto gli stereotipi in cui siamo immersi. Se gli chiedete una immagine di un chirurgo andrà a pescare quella di un uomo perché la maggiore parte dei medici chirurghi è un uomo. La situazione negli ospedali sta cambiando ma non ovunque. Nessuno ha aggiornato i dati o glielo ha suggerito.

C’è stato un momento in cui sono stati incolpati gli sviluppatori – i programmatori – accusati di essere in maggioranza maschi e quindi poco inclusivi nell’inserimento dei dati. In realtà mitigare questi bias dell’intelligenza artificiale generativa non è semplicissimo. Pensate solo agli stereotipi di genere all’interno della società. Si può lavorare sui dataset è possibile impostare dei “guard rail” che tengano conto dei cambiamenti che vogliamo all’interno della nostra società. Ma dobbiamo poi anche spiegare che quando si entra in una narrazione storica dobbiamo tenere presente del contesto e non di quello che vorremmo. Se non vogliamo che non si scateni ad ogni errore il solito circo di accuse contro il chatbot ignorante, omofobo, volgare e razzista dobbiamo capire che queste tecnologie non distinguono (per ora) i contesti storici. Sono pappagalli stocastici che non discrimino tra quello che vorremmo e quello che è stato. Eseguono dei calcoli. Dobbiamo scegliere noi se allevarli/e per raccontare il migliore dei mondi possibili o se ripetere quello che la maggioranza dice. Per ora, e sottolineo per ora nel modo più luciferino possibile, siamo noi a controllare il loro dataset.