Nel luglio 2025, dopo anni di presenza sul mercato, Woebot Health ha deciso di ritirare dal mercato il suo prodotto principale, un chatbot terapeutico molto usato e considerato all’avanguardia. L’app per smartphone presentava un bot in stile cartoon che guidava le persone attraverso conversazioni volte ad affrontare l’ansia o i problemi quotidiani, utilizzando tecniche radicate nella terapia cognitivo-comportamentale. Si trattava di una app testata e riconosciuta dalla FDA per l’uso terapeutico in aree come la depressione post-partum. Circa 1,5 milioni di persone hanno utilizzato Woebot nel corso degli anni e, sebbene avesse l’aspetto interattivo di ChatGPT e di prodotti di intelligenza artificiale generativa simili, le risposte e il comportamento del bot erano preimpostati. Appena nel 2023, la creatrice di Woebot e psicologa clinica Alison Darcy, era stata nominata tra le 100 figure più importanti nel campo dell’intelligenza artificiale dalla rivista TIME.

Con il moltiplicarsi degli studi che esplorano il potenziale dei chatbot conversazionali basati sull’IA in ambito sanitario, è evidente che questi strumenti offrono vantaggi assenti nei precedenti approcci alla salute digitale. Le capacità generative dei sistemi di nuova generazione hanno superato i limiti dei chatbot basati su regole e delle app per la salute mentale, mostrando una maggiore abilità nell’acquisire conoscenze mediche, sintetizzare informazioni, personalizzare piani di cura e potenzialmente ampliarsi per un uso più esteso nei servizi di salute mentale.

All’inizio di quest’anno è stato pubblicato il primo studio randomizzato su un chatbot basato sull’IA generativa, Therabot, per il trattamento della salute mentale. Ne avevamo parlato anche su Infodata: in sintesi l’intervento tramite Therabot è stato confrontato con un gruppo di controllo in lista d’attesa in adulti con disturbo depressivo maggiore, disturbo d’ansia generalizzato o a rischio di disturbi alimentari e della nutrizione, e ha mostrato un miglioramento dei sintomi a 4 e 8 settimane.

Se il mercato galoppa, la comunità scientifica cerca di tenere il punto, rimarcando che mancano ancora studi ampi e solidi per confermarne l’efficacia e la generalizzabilità di questi strumenti. Anche le autorità di regolamentazione, come la Food and Drug Administration statunitense, faticano a orientarsi in questo scenario in rapido mutamento.

Non siamo lontani da ciò che è accaduto (e in verità sta ancora accadendo) rispetto all’utilizzo delle app di salute, che hanno iniziato a popolare le nostre vite un decennio fa. Intorno al 2014 il dibattito era come classificare questi strumenti, il cui numero cresceva sempre di più mese dopo mese, alla luce di una regolamentazione sostanzialmente inesistente in grossa parte del mondo che differenziasse fra dispositivi medici sottoposti a studi clinici solidi, e quelli che non lo erano. Perché se da una parte l’Europa aveva piuttosto presto fissato i criteri che definivano quando una app era un reale dispositivo medico, si potevano comunque vendere tranquillamente app che non lo fossero; bastava specificare, appunto, che non lo erano.

Rispetto ai sistemi di IA la dinamica è grosso modo la stessa, ma con risultati potenzialmente più impattanti.

Come orientarsi dunque?

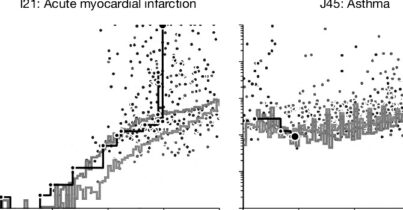

Eric Topol, tra i massimi esperti internazionali di questi temi, ha pubblicato su The Lancet un vademecum su come dovrebbe essere validato un sistema di IA che ambisce a occuparsi di salute mentale. La prima questione riguarda la qualità delle prove a supporto di qualsiasi affermazione. Un decennio di esperienza con le app di salute digitale ha mostrato i limiti del confronto con controlli in lista d’attesa, poiché la mancanza di placebo o di un gruppo di controllo attivo rende gli studi più esplorativi che conclusivi, analogamente a quanto accade con le fasi iniziali della sperimentazione farmacologica. Lo stesso vale per i chatbot: confrontarli con il nulla, o con una semplice lista d’attesa, appare riduttivo, considerando la vasta gamma di interventi digitali disponibili che potrebbero rappresentare un controllo attivo più adeguato.

Un secondo punto riguarda l’impatto a lungo termine dei sistemi, che vada oltre la riduzione dei sintomi nell’immediato. Le analisi economiche che valutano i risparmi sui costi degli strumenti di intelligenza artificiale si basano anch’esse su risultati duraturi. È possibile che l’IA riesca a fornire interventi così efficaci da ridurre la necessità di un supporto continuativo, oppure che favorisca essa stessa un coinvolgimento prolungato, ma per comprenderlo servono ricerche approfondite e di lungo respiro.

Infine, qualsiasi pretesa terapeutica attribuita all’IA generativa deve essere inserita nel contesto più ampio dei trattamenti e della responsabilità medica. Se un sistema non è in grado di assumersi responsabilità legali e rischi clinici, non può erogare assistenza. Oggi, perché l’IA possa supportare la salute mentale, resta indispensabile il ruolo degli operatori sanitari nel monitoraggio della sicurezza. Il fatto che la responsabilità resti agli esseri umani suggerisce che l’IA, da sola, non possa farsi carico dell’assistenza. Saranno dunque gli sviluppi legali e normativi a determinare se e come questi strumenti potranno davvero integrarsi nella pratica clinica, mentre la ricerca condotta fuori dai contesti sanitari reali rimane limitata per valutare costi, efficacia e ruolo degli operatori.

“Il problema difficile della coscienza”

Di questo Topol non si occupa, ma è difficile affrontare il tema senza evocare una questione ben più antica, che accompagna la storia della salute mentale da secoli: dobbiamo considerarla soltanto come la salute fisica del cervello, o c’è qualcosa di ulteriore? Rimane aperto l’interrogativo se la mente possa davvero essere compresa e trattata attraverso algoritmi, per quanto sofisticati, oppure se esista una dimensione irriducibile che richiede un approccio relazionale umano, qualunque significato abbia oggi questa parola.

David Chalmers, tra i massimi filosofi contemporanei della mente, distingue a questo proposito tra il “problema facile” e il “problema difficile” della coscienza. I primi riguardano le funzioni cognitive come linguaggio, memoria o attenzione: capacità che, almeno in linea teorica, un sistema artificiale potrebbe replicare. Il problema difficile, invece, riguarda l’esistenza stessa dell’esperienza soggettiva: che cosa significa provare qualcosa, essere un soggetto cosciente? Perché l’elaborazione dell’informazione dà origine alla consapevolezza in un cervello umano, ma non — almeno per ora — in una macchina? È qui che Chalmers colloca il nucleo più misterioso della coscienza: capire perché e come processi fisici possano generare esperienza vissuta.

Per approfondire.

L’illusione del “parental control” nell’era dell’intelligenza artificiale

Informazione, trasparenze e buonsenso per affrontare la psicosi da intelligenza artificiale

ChatGPT è sempre di più psicologo e confidente a sua insaputa