In occasione della conferenza Computer Vision and Pattern Recognition 2022 in Louisiana il team creativo e di ricerca del produttore di schede grafiche Nvidia ha presentato una nuova ricerca sull’intelligenza artificiale in grado di trasformare le foto in oggetti 3D. Nel video sopra in stile jazz che rende omaggio alla sede della CVPR di quest’anno, New Orleans viene illustrato come funziona il rendering inverso, una tecnica che permette di ricostruire da una serie di foto un modello 3D di un oggetto o di una scena. Parliamo, come hanno giustamente sottolineato i ricercatori, del Santo Graal dell’animazione perché unisce la computer vision e la computer grafica. Lo strumento si chiama Nvidia 3D MoMa ma noi ci accontenteremo di chiamarlo MoMa.

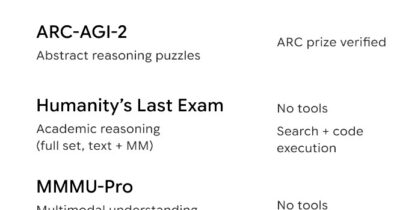

Come funziona. Prima una premessa: per risultare più utile a un artista o a un ingegnere, un oggetto 3D deve avere una forma che possa essere inserita in strumenti di uso comune come i motori di gioco, i modellatori 3D e i renderizzatori cinematografici. Questa forma è un triangolo con materiali texturizzati, il linguaggio comune utilizzato da questi strumenti 3D. MoMa genera modelli di mesh triangolari in una sola ora su una singola Gpu Nvidia Tensor Core. L’output del lavoro è direttamente compatibile con i motori grafici 3D e gli strumenti di modellazione che i creatori già utilizzano. Cosa vuole dire? .

Perché è un vantaggio? Tradizionalmente, gli studi di videogiochi e i creator producono oggetti 3D come questi attraverso complesse tecniche di fotogrammetria che richiedono un notevole dispendio di tempo. Nel video hanno iniziato raccogliendo circa 100 immagini di cinque strumenti che compongono una jazz band – tromba, trombone, sassofono, batteria e clarinetto – da diverse angolazioni. Lo strumento di Nvidia ha ricostruito queste immagini 2D in rappresentazioni 3D di ogni strumento e ha quindi estratto gli strumenti dalle scene originali e li ha importati nella piattaforma di simulazione 3D NVIDIA Omniverse per modificarli. I creator possono quindi inserire gli oggetti appena modificati in qualsiasi scena virtuale. Rispetto a Instant Nerf sempre di Nvidia di cui abbiamo già parlato, questo nuovo tool non si limita all’acquisizione. Gli oggetti e le scene create tramite MoMa possono essere modificati e importati in altri software come i motori grafici dei videogiochi e si possono gestire alcune caratteristiche come illuminazione, materiale e dimensione dell’oggetto.

Per approfondire.

Così l’intelligenza artificiale trasforma le foto in oggetti a tre dimensioni #imaging

Le creature fantastiche create da un artista italiano con la potenza delle Gpu #imaging

Volto e capelli umani iper-realistici. La nuova tech demo di Unity