Sì, queste piattaforme esistono già, sono operative, si stanno espandendo. Al momento (marzo 2025) i risultati che abbiamo sono preliminarissimi, ma ci suggeriscono che ci sono più errori negli studi scientifici pubblicati di quanti – forse – immaginiamo. Black Spatula, Yesnoerror, TruLyzer, ScholarlyAI: sono solo alcune delle iniziative nate “dal basso” ossia non in seno a istituzioni scientifiche, con l’obiettivo di passare al setaccio gli articoli scientifici pubblicati per individuare eventuali errori metodologici, o addirittura di calcolo.

Alla fine dello scorso anno, i media di tutto il mondo hanno avvertito che le posate di plastica nere contenevano livelli preoccupanti di ritardanti di fiamma collegati al cancro. A una più attenta analisi, alcuni ricercatori si sono resi conto che in realtà rischio era stato sovrastimato, per colpa di un errore matematico nella ricerca di base, che suggeriva che una sostanza chimica superasse il limite di sicurezza, mentre in realtà era dieci volte inferiore al limite.

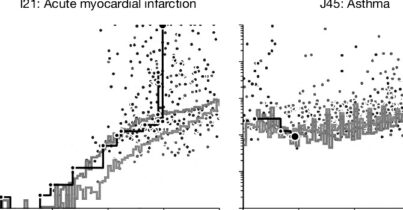

Uno studio condotto in collaborazione tra l’Università Cattolica del Sacro Cuore di Roma e la Stanford University e pubblicato su PLOS Biology a fine gennaio 2025, ha messo in luce che anche i ricercatori più citati al mondo sono coinvolti in casi di ritrattazioni scientifiche, ovvero la rimozione di articoli pubblicati a causa di errori o problemi legati all’integrità della ricerca.

La ricerca ha esaminato i dati sulle ritrattazioni scientifiche confrontandoli con quelli di un database aggiornato basato su Scopus, che include gli scienziati più citati, ossia quelli appartenenti al top 2% in ogni sottocampo scientifico. Sono stati analizzati 55.237 articoli fino al 15 agosto 2024, di cui 39.468 erano ritrattazioni dovute a cattiva condotta dell’autore.

Il Black Spatula Project

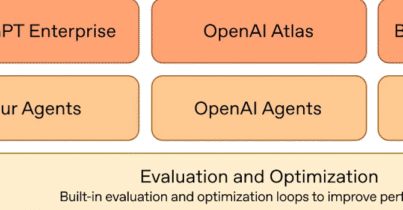

L’incidente delle posate di plastica ha dato il via al Black Spatula Project (il nome Black spatula si riferisce appunto alle posate di plastica nere), uno strumento open-source basato su AI che finora ha analizzato circa 500 articoli alla ricerca di errori. Black Spatula funziona così: il sistema estrae prima le informazioni, comprese tabelle e immagini, dagli articoli. Poi crea un set di istruzioni complesse, noto come “prompt”, che dice a un “modello di ragionamento” — un tipo di LLM specializzato — cosa sta esaminando e che tipo di errore deve cercare. Il modello potrebbe analizzare un articolo più volte, sia per cercare diversi tipi di errore ogni volta, sia per incrociare i risultati. Il gruppo conta circa otto sviluppatori attivi e centinaia di consulenti volontari.

Quando viene individuato un errore infatti, invece di rendere immediatamente pubbliche le scoperte, il progetto contatta direttamente gli autori per affrontare la questione in modo discreto e collaborativo, riducendo i rischi reputazionali per i ricercatori e permettendo di correggere gli errori senza compromettere l’affidabilità delle pubblicazioni. La natura open-source consente a chiunque sia interessato di contribuire, sia come sviluppatore che come consulente per la revisione degli articoli scientifici, creando una comunità globale di ricercatori e esperti che offrono feedback sui risultati dell’IA. Il progetto, che non è legato a università o istituzioni accademiche, opera in modo autonomo grazie alla partecipazione di una rete internazionale di volontari. Joaquin Gulloso, ricercatore indipendente in AI con sede a Cartagena, in Colombia, che aiuta a coordinare il progetto, ha dichiarato a Nature: “già ora stiamo individuando molti errori. È una lista enorme”.

Alcuni pagano i fact-checkers in criptovaluta

Un’altra piattaforma è YesNoError, un progetto che utilizza l’intelligenza artificiale per individuare errori nella ricerca scientifica, puntando a segnalarli per la correzione prima che vengano pubblicati ufficialmente.

A differenza di altre iniziative, YesNoError si appoggia a un’altra piattaforma, ResearchHub https://x.com/researchhub che si avvale della collaborazione di ricercatori in carne e ossa in cambio di criptovaluta. Quando l’IA individua un errore in un articolo, il sistema segnala la potenziale discrepanza, e un team di ricercatori umani la vaglia.

Troppi falsi positivi, per ora

Il tasso di falsi positivi, ovvero i casi in cui l’intelligenza artificiale segnala un errore che in realtà non esiste, rappresenta una delle principali difficoltà nella gestione dei progetti come Black Spatula e YesNoError. Al momento, il sistema utilizzato dal Black Spatula Project è impreciso circa il 10% delle volte. Allo stesso modo, il team di YesNoError ha affrontato una sfida simile nella quantificazione dei falsi positivi. Finora, gli esperti hanno esaminato circa 100 errori matematici in un primo lotto di 10.000 articoli, riscontrando che il 90% degli autori che hanno risposto ha confermato la validità dell’errore rilevato, tranne in un solo caso. Il servizio prevede a breve di collaborare con ResearchHub, una piattaforma che paga i ricercatori in criptovaluta per eseguire revisioni tra pari, per migliorare il processo di verifica. Questo sistema prevede che, una volta che l’intelligenza artificiale avrà analizzato un articolo, venga inviata una richiesta agli esperti per confermare i risultati.

La maggior parte dei problemi rilevati riguardano errori di scrittura. Questo potrebbe tradursi in un eccesso di lavoro per la comunità scientifica, creando polemiche su errori minori, come refusi, che dovrebbero essere facilmente individuati durante la revisione tra pari. La piattaforma, infatti, si concentra principalmente sugli articoli nei repository di preprint, aumentando ulteriormente la probabilità che i falsi positivi riguardino problemi di forma piuttosto che contenuto scientifico rilevante. Se la tecnologia non migliorasse drasticamente, questi strumenti non porterebbero alcun beneficio tangibile, ma genererebbero solo lavoro inutile.

Un’altra questione rilevante all’orizzonte in piattaforme di questo genere è che cosa accadrebbe se si permettesse ai detentori di criptovaluta di decidere quali articoli esaminare prima, con l’intento di concentrarsi su ricerche che abbiano un impatto pubblico significativo. Questo approccio possa concentrarsi su ricerche politicamente sensibili, come la scienza climatica, oppure sulle priorità di altri portatori di interesse.