Il 14% degli abstract in ambito biomedico ha tracce di IA. Uno su sette – oltre 200.000 – include infatti parole rivelatrici, comuni nei testi generati da modelli linguistici di grandi dimensioni. La percentuale di abstract manipolati con l’IA sale al 40% per alcuni ambiti. Lo evidenzia un articolo pubblicato su Science, che ha studiato i cambiamenti del vocabolario in oltre 15 milioni di abstract di articoli in ambito biomedico dal 2010 al 2024 indicizzati da PubMed.

L’effetto dell’utilizzo degli LLM sulla scrittura scientifica è davvero senza precedenti e supera persino i notevoli cambiamenti nel vocabolario indotti dalla pandemia di COVID-19.

Tra tutte le 26.657 parole esaminate, i ricercatori ne hanno individuare 454 che sono apparse molto più spesso nel 2024 che in qualsiasi altro anno dal 2010. Si trattava principalmente di termini di “stile” non correlate al contenuto della ricerca e tendevano a essere verbi e aggettivi. Fra queste le più usate sono risultate essere: delves, underscores, showcasing, potential, findings, e crucial.

L’IA generativa è stata più impattante della pandemia

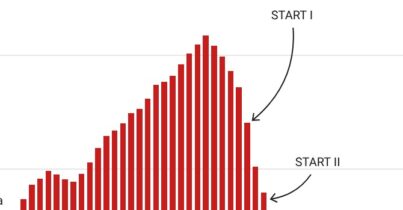

I cambiamenti nel lessico scientifico avvengono nel tempo, ed è normale che sia così. Pensiamo per esempio alle modifiche radicali che hanno accompagnato eventi importanti, come la pandemia di COVID-19. Nel 2021 si sono registrate 190 parole con occorrenze in eccesso, tendenzialmente sostantivi correlati al contenuto della ricerca, come “mascherina”. Ma il cambiamento lessicale avvenuto da quando gli LLM sono diventati popolari è stato ancora più pronunciato, e principalmente stilistico.

Per fare un confronto, i ricercatori hanno effettuato la stessa analisi per tutti gli anni dal 2013 al 2023. Le occorrenze di parole come ebola nel 2015 e zika nel 2017 sono cresciute moltissimo, ma dal 2013 al 2019 nessun termine ha mai mostrato un eccesso di frequenza molto elevata. La situazione è un po’ cambiata durante la pandemia di COVID: nel 2020-2022, parole come coronavirus, covid, lockdown e pandemia hanno mostrato un eccesso di utilizzo molto elevato. Tuttavia, utilizzando l’insieme di quattro parole in eccesso del 2021 – Covid, pandemic, Coronavirus e Sars – (qualsiasi articolo scientifico sul COVID-19 probabilmente conteneva almeno una di queste quattro parole nel suo abstract), si è ottenuto un gap di frequenza Δ = 0,069. Ebbene: l’utilizzo di LLM nel 2024 era almeno due volte superiore alla dimensione della letteratura relativa al COVID nel 2021.

Tre esempi di linguaggio tipico dell’IA

By meticulously delving into the intricate web connecting […] and […], this comprehensive chapter takes a deep dive into their involvement as significant risk factors for […].

A comprehensive grasp of the intricate interplay between […] and […] is pivotal for effective therapeutic strategies.

Initially, we delve into the intricacies of […], accentuating its indispensability in cellular physiology, the enzymatic labyrinth governing its flux, and the pivotal […] mechanisms.

Grosse differenze da rivista a rivista

Tra le singole riviste, abbiamo riscontrato valori di Δ molto elevati, ad esempio 0,25 per Sensors [rivista open access pubblicata dal Multidisciplinary Digital Publishing Institute (MDPI)] e 0,20 per Cureus (rivista open access con processo di revisione semplificato, pubblicata da Springer Nature). Abbiamo analizzato diversi gruppi di riviste raggruppate e abbiamo riscontrato un Δ elevato per le riviste MDPI (0,21) e Frontiers (0,20). Per riviste molto selettive e di alto prestigio come Nature, Science e Cell, e per le riviste della famiglia Nature, il Δ era molto più basso (rispettivamente 0,07 e 0,10), suggerendo che un utilizzo facilmente rilevabile dell’LLM fosse negativamente correlato al prestigio percepito.

Più di un abstract su cinque con tracce di IA proveniva da alcuni paesi, tra cui Cina e Corea del Sud, e afferiva ad alcuni campi più che in altri, come l’informatica e la bioinformatica. Bisogna tenere presente, e lo scrivono anche gli autori, che nei paesi non anglofoni, gli LLM possono aiutare gli autori nella revisione di testi in inglese, il che potrebbe giustificarne l’ampio utilizzo.

Un tema difficile da studiare

L’utilizzo dell’intelligenza artificiale negli articoli potrebbe essere persino superiore a quanto suggerito dall’ultimo studio. Un preprint pubblicato sul server arXiv a febbraio 2025, evidenzia che alcune parole e frasi rivelatrici, come “delves”, sono diventate meno frequenti verso la fine del 2024. Ciò potrebbe essere dovuto al fatto che gli studi che le segnalano come indicatori dell’utilizzo dell’IA hanno portato gli autori a rimuovere tali elementi dal testo o a modificare le loro richieste LLM per evitarli.

Il punto è che attualmente gli studi, inclusi questi appena citati, non sono in grado di determinare come siano stati utilizzati gli strumenti di IA. Gli autori avrebbero potuto usarli per applicazioni meno impattanti come la rifinitura del testo e l’assistenza alla traduzione, o per pratiche più discutibili, come la generazione di grandi porzioni di testo senza un’adeguata supervisione. Gli autori che pubblicano su riviste con processi di revisione accelerati e/o semplificati potrebbero essere interessati agli LLM per scrivere articoli che richiedono poco sforzo.

Gli LLM sono noti per inventare riferimenti bibliografici, fornire riassunti inaccurati e formulare false affermazioni che suonano autorevoli e convincenti. Mentre i ricercatori possono notare e correggere errori fattuali nei riassunti assistiti da LLM dei propri lavori, potrebbe essere più difficile individuare errori nelle revisioni della letteratura o nelle sezioni di discussione generate dagli LLM. Inoltre, gli LLM possono imitare distorsioni e altre carenze presenti nei loro dati di training o addirittura commettere plagio. Questo rende i risultati degli LLM meno diversificati e innovativi rispetto ai testi scritti da esseri umani.

Tale omologazione può inoltre degradare la qualità della scrittura scientifica. Ad esempio, tutte le introduzioni generate dagli LLM su un determinato argomento potrebbero suonare identiche e contenere lo stesso insieme di idee e riferimenti.

Per approfondire.

Come cambia la ricerca di informazioni sul web nell’era dell’intelligenza artificiale generativa?

Medicina, l’intelligenza artificiale è pronta a entrare in corsia e cambierà tutto: ecco perché

Come cambia la ricerca sul web con i nuovi motori potenziati con l’Ai?